TEORÍA DE REDES NEURONALES

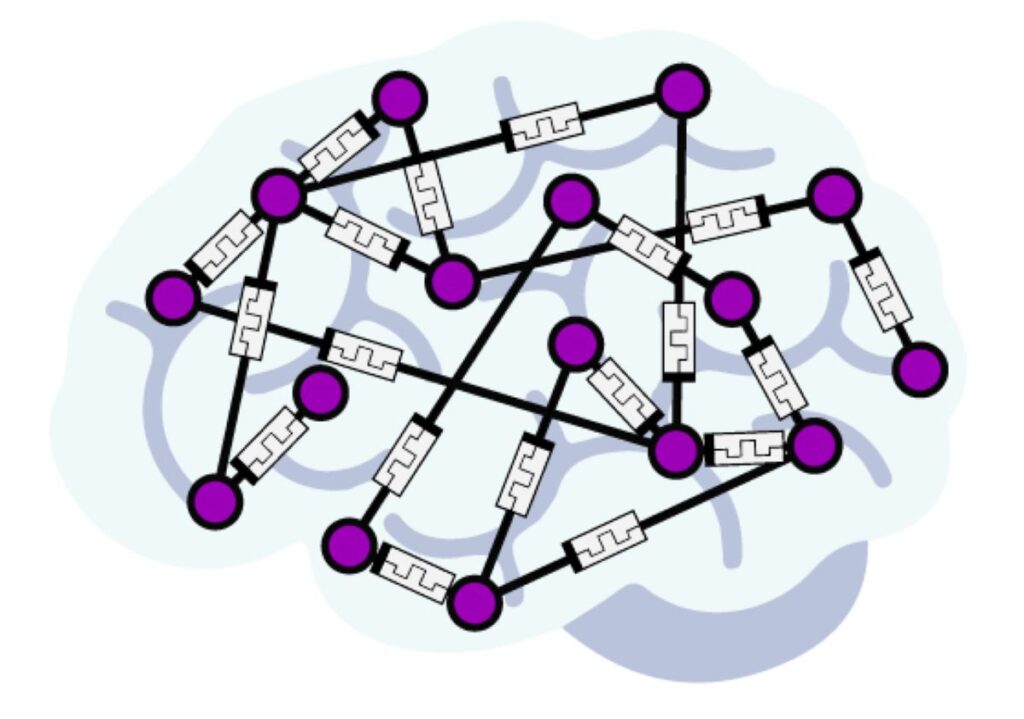

La teoría de redes neuronales es un paradigma de aprendizaje automático inspirado en la estructura y funcionamiento del cerebro humano para diseñar modelos computacionales capaces de aprender y realizar tareas específicas. Estas redes están compuestas por capas de nodos interconectados, denominados neuronas artificiales. La información fluye a través de estas conexiones, y durante el entrenamiento, la red ajusta los pesos de estas conexiones para mejorar su rendimiento en la tarea deseada.

Este modelo se ha utilizado con éxito en diversas áreas, como reconocimiento de patrones, procesamiento de lenguaje natural y visión por computadora. La capacidad de las redes neuronales para aprender de datos complejos y no lineales ha contribuido significativamente a avances en inteligencia artificial y aprendizaje automático.. Aquí hay algunas características clave y cómo se puede aplicar:

- Estructura:

Las redes neuronales consisten en capas de nodos llamados neuronas, organizadas en capas de entrada, capas ocultas y capas de salida.

Las conexiones entre las neuronas tienen pesos que se ajustan durante el entrenamiento.

- Aprendizaje:

El aprendizaje se realiza a través de un proceso iterativo llamado entrenamiento, donde la red ajusta sus pesos para minimizar la diferencia entre las predicciones y los resultados deseados. Se utilizan algoritmos de retropropagación para actualizar los pesos en función del error.

En resumen, las redes neuronales son poderosas para abordar problemas complejos de aprendizaje automático, pero su aplicación efectiva requiere comprensión de la estructura, el proceso de entrenamiento y la selección adecuada para la tarea específica.

Comentarios

Publicar un comentario